개발환경

- Windows 10 pro 64bit

- Visual studio 2019(Intel(R) C++ Complier)

- Visual Studio Code (version 1.59.0)

- Node.js (version 14.16.0)

- Jupyter Notebook

- dlib (version 19.22.1)

- OpenCV

- React (version 17.0.2)

- Ubuntu (version 20.04)

- oracle cloud

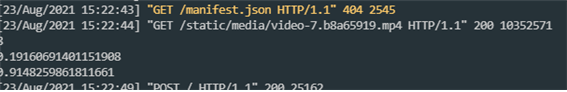

- Django (version 3.2.6)

소스 코드

https://github.com/Seo-sang/Stroke_Self_Diagnosis

GitHub - Seo-sang/Stroke_Self_Diagnosis

Contribute to Seo-sang/Stroke_Self_Diagnosis development by creating an account on GitHub.

github.com

위 링크의 장고 웹서버를 포함한 모든 소스코드는 django2 branch에 존재한다.

master branch에는 리액트 프론트엔드와 머신러닝을 활용한 학습 및 예측하는 코드가 존재한다.

느낀점

이번 공모전을 통해 오픈소스를 실제로 사용해보고 깃허브를 통해 팀원들과 한 repository에 push, pull하며 함께 프로그램을 만들고 실수도 많이 해보며 많이 배울 수 있었고 여러가지 오류들을 접하며 구글링을 통해 대처하고 해결하는 능력도 키울 수 있었던 것 같다.

여러가지 프로그램을 설치해야하고 팀원과의 환경이 달라 내 PC에서는 동작하지 않은 문제들을 접하며 다른 사람들이 동작시킬 때에도 무엇이 문제가 될지를 생각해볼 수 있었다. 또 http를 사용할 때 보안문제로 인해 웹캠이 실행되지 않은 문제가 있었다. 따라서 localhost를 이용할 때는 문제가 없었지만 외부망에서 접속할 때 문제가 생겼다. 이를 해결하기 위해선 ssh로 접속해야하는 부분을 추가해야하지만 이 부분까지는 고려하지 못했다. 계속 수정할 계획이기 때문에 해결될 경우 다시 글을 적어보도록 하겠다.

많은 것을 배울 수 있는 공모전이었고 동기들과 팀을 이뤄 원했던 결과가 딱 뜨는 순간 희열을 느낄 수 있었다. 마무리를 할 수 있어 굉장히 뿌듯했고 다음 번에는 또 다른 주제로 공모전에 참가해보도록 하겠다.

시연 영상

https://www.youtube.com/watch?v=i8v_ckeE2G4

'프로젝트 > 2021 소프트웨어 공모전' 카테고리의 다른 글

| [2021 소프트웨어 공모전] 장고 프레임 워크를 활용한 백엔드 구현기능 (0) | 2021.08.26 |

|---|---|

| [2021 소프트웨어 공모전] 리액트를 활용한 프론트엔드 구현기능 (0) | 2021.08.26 |

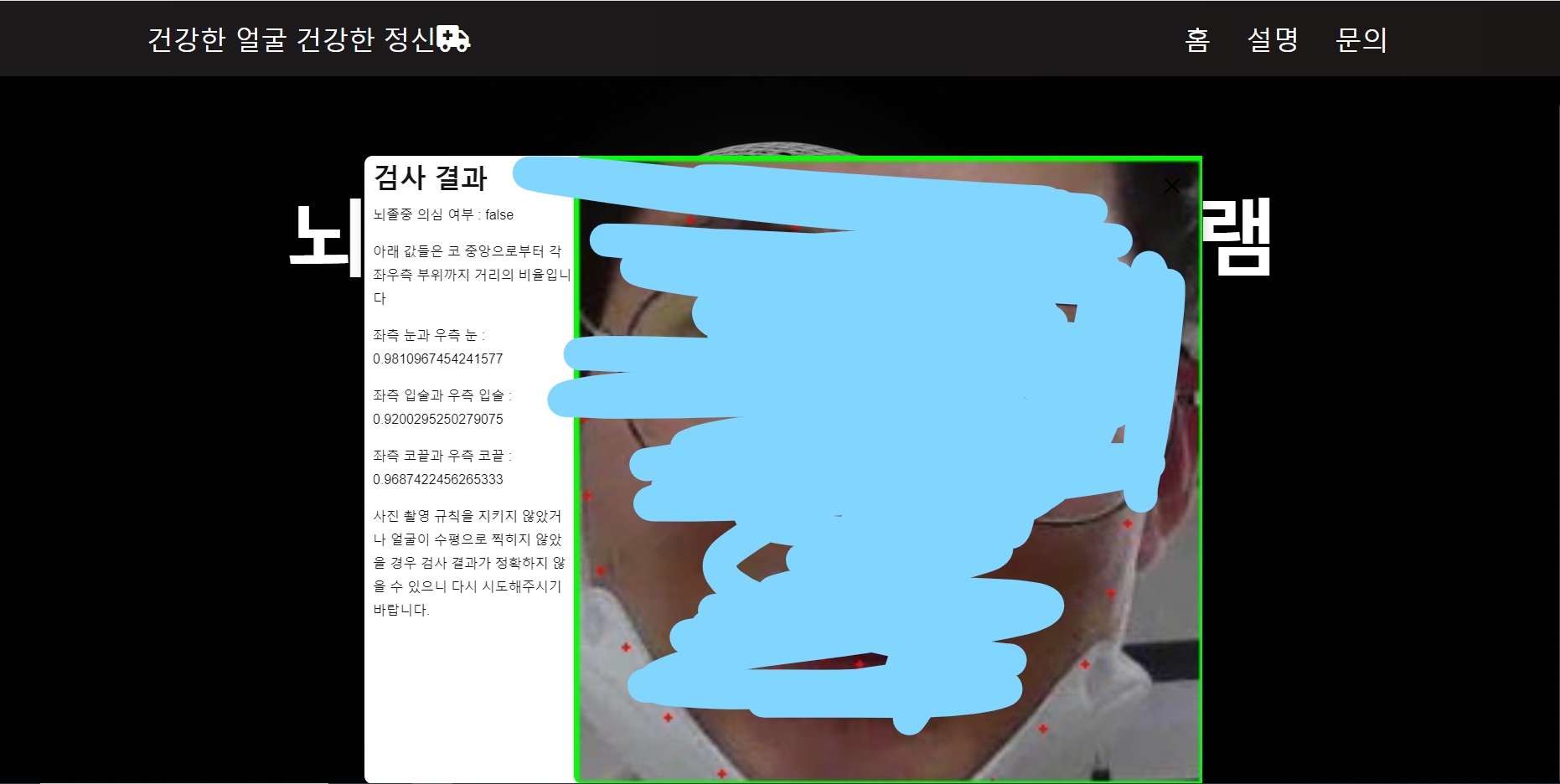

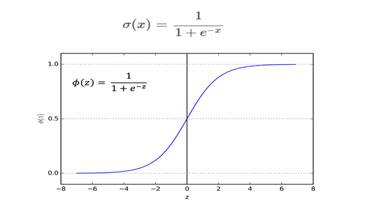

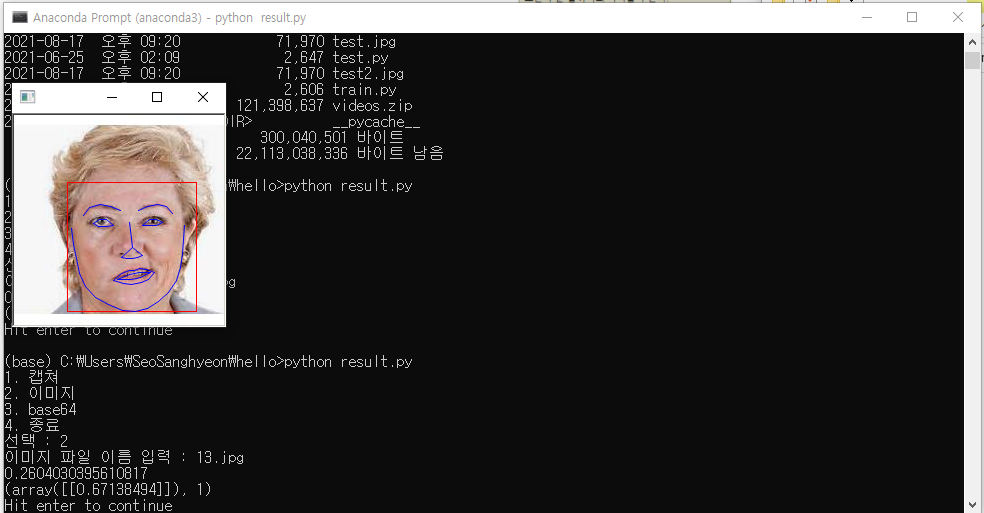

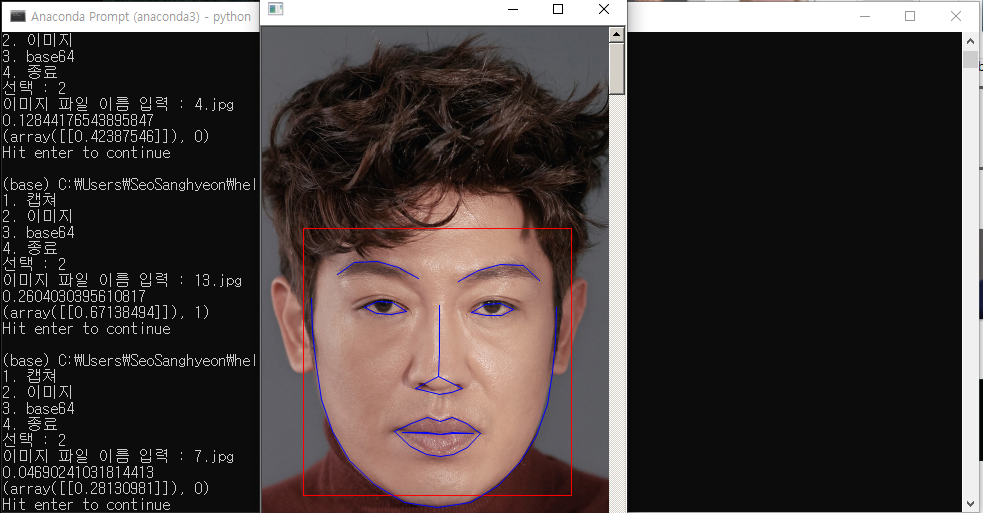

| [2021 소프트웨어 공모전] 안면비대칭 계산 방법과 결과 예측 (0) | 2021.08.21 |

| [2021 소프트웨어 공모전] 작품 설명 (0) | 2021.08.21 |

| [2021 소프트웨어 공모전] 기획 의도 (0) | 2021.08.21 |